Adam通常需要比SGD更多的regularization,因此在从SGD切换到Adam时,请务必调整正则化超参数。 以下是本文其余部分的概述: 1 AdamW 1.1 了解AdamW 1.2 实现AdamW 1.3 AdamW实验的结果 2 Amsgrad 2.1 了解Amsgrad 2.2 实现Amsgrad 2.3 Amsgrad实验的结果 3 完整结果表 1 AdamW

基于实验结果,本文总结了Adam优化器及其改进版本在实际应用中的表现。适当调整参数的Adam在训练深度学习模型时展现出高效性,尤其是在具有复杂结构的任务中。AdamW通过修正原始Adam中的正则化问题,提高了优化器的稳定性与泛化能力。尽管Amsgrad试图解决Adam的收敛性问题,其在某些任务上的表现并未超越其他优化...

Adam和AdamW区别什么是混合精度训练 算一下对显存能减少多少占用 ZERO1 2 3TFIDF是什么国内有哪些大模型 结构是什么怎么处理AI幻觉模型训练是怎么训练的 怎么并行怎么分布式还有一些项目的细节然后就是手撕leetcode的一个中等题 五分钟解决反问什么是飞星计划? 算是一个提前批我有什么能提高的?NLP的细节需要再深入一...

一文告诉你Adam、AdamW、Amsgrad区别和联系 重点 **序言:**Adam自2014年出现之后,一直是受人追捧的参数训练神器,但最近越来越多的文章指出:Adam存在很多问题,效果甚至没有简单的SGD + Momentum好.因此,出现了很多改进的版本,比如AdamW,以及最近的ICLR-2018年最佳论文提出的Adam改进版Amsgrad.那么,Adam究竟是否有效?

Ilya Loshchilov和Frank Hutter在他们的论文《Fixing Weight Decay Regularization in Adam》中指出,所有的深度学习库中的Adam optimizer中实现的weight decay方法似乎都是错误的,并提出了一种简单的方法(他们称之为AdamW)来解决它。尽管他们的结果略有不同,但从下图的效果对比图中可以发现,结果令人振奋,:...

Ilya Loshchilov和Frank Hutter在他们的论文《Fixing Weight Decay Regularization in Adam》中指出,所有的深度学习库中的Adam optimizer中实现的weight decay方法似乎都是错误的,并提出了一种简单的方法(他们称之为AdamW)来解决它。尽管他们的结果略有不同,但从下图的效果对比图中可以发现,结果令人振奋,:...

Adam和AdamW的对比 我们当然期待看到Adam的回归,因为似乎最初的结果可能会再次被发现。但事情并非如此。实际上,所有深度学习框架中,只有fastai,由Sylvain编写的代码中的的算法实现修复了这一bug。如果没有广泛的框架可用性,大多数人仍旧会被old、“broken”adam所困扰。

Adam和AdamW的对比 我们当然期待看到Adam的回归,因为似乎最初的结果可能会再次被发现。但事情并非如此。实际上,所有深度学习框架中,只有fastai,由Sylvain编写的代码中的的算法实现修复了这一bug。如果没有广泛的框架可用性,大多数人仍旧会被old、“broken”adam所困扰。

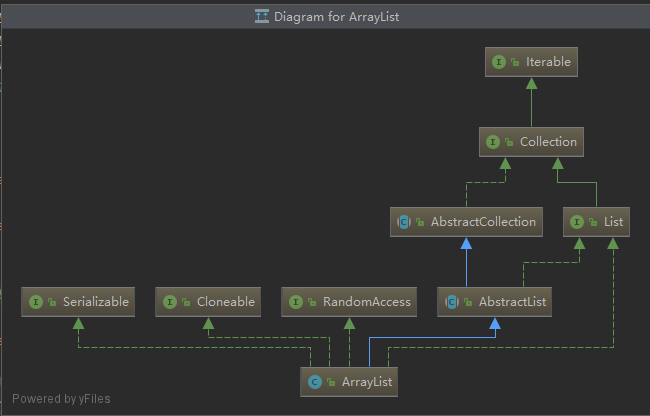

一文告诉你Adam、AdamW、Amsgrad区别和联系 重点 2019-07-25 10:33 −... 交流_QQ_2240410488 0 3753 ArrayList实现原理(JDK1.8) 2019-11-30 19:14 −### ArrayList实现原理(JDK1.8)  ``` java public cla...